北京时间2026年1月1日,DeepSeek团队在arXiv(预印本)网站和Hugging Face上同步发布了最新论文,名为《mHC: Manifold-Constrained Hyper-Connections》,论文的核心观点是提出一种名为“mHC”(直译为“流形约束超连接”)的框架,该框架改进了此前大模型训练中一种名为“HC(Hyper-Connections,超连接)”的范式,对大规模模型训练提供了切实的性能改进。

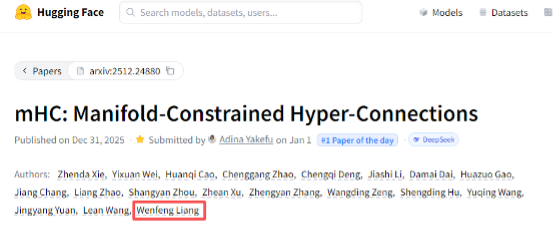

贝壳财经记者注意到,DeepSeek创始人梁文锋的名字出现在了这篇论文署名作者的最后一位上。事实上,虽然DeepSeek在2025年春节因为R1模型的开源发布而全球爆火,但在梁文锋的带领下,这家公司极其低调,团队一直潜心学术,未做过多的商业化尝试,一心扑在基础模型理论研发之上,梁文锋还在近期入选了《自然》2025年影响科学发展十大人物。

梁文锋的名字出现在论文作者最后一位。Hugging Face网站截图

论文重点讲了什么?

破解大模型训练拥堵难题

贝壳财经记者梳理发现,DeepSeek团队本次发布的论文瞄准了大模型训练的“地基”——残差连接范式,以及为了升级残差连接范式提出的HC(超连接)范式,是不折不扣的一次基础理论创新。

DeepSeek团队在论文中以严谨的数学公式解释了mHC,若以简单的语言来类比,大致可以理解为,残差连接是AI模型训练的“生命线”——它像一条单车道高速公路,让数据信号可以跳过某些层直接连接,从而解决了在此之前神经网络越大训练越困难的问题。

但随着大模型参数突破千亿,这条“单车道”越来越不够用,此时超连接(HC)范式登场,其把单车道扩建成多车道,从而显著提升了模型性能。但与此同时,过多的数据信号也导致了“堵车撞车”,就像多车道中没装 “交通信号灯”一样,使模型训练变得更加不稳定,容易崩溃。

此时,DeepSeek提出了一种新算法,给“多车道”增加了一套智能调度系统(即mHC“流行约束”),其要求每个路口的车必须全部分流出去,每个车道接收的车数量固定,从而大大增加了模型训练的稳定性。

论文配图HC与mHC的训练损失差距,其中淡蓝色线为HC,蓝色线为mHC。论文截图

最终,DeepSeek在论文中以直观的测试展示了mHC方法相对于HC的稳定性。

理论创新

站在何凯明团队和字节跳动的肩膀上

值得注意的是,本次DeepSeek的论文,是站在了AI“大神”何凯明以及字节跳动的肩膀上。

这是因为,残差连接正是2015年由何凯明等人在微软亚洲研究院所提出的,何恺明还因此获得了CVPR 2016最佳论文奖,残差连接之后也成了几乎所有主流大模型的“标配”。

直到2024年,为了解决残差连接信号通道不够“宽阔”的问题,字节跳动旗下团队提出了HC(超连接)范式,但由此也带来了稳定性不够的问题。而DeepSeek正是在前人的基础上进一步进行了优化。

2026年的第一天,在诸多大模型公司聚焦商业化和变现之际,DeepSeek此举进一步证实了自己在基础模型领域的战略定力。

在本次发布论文的文末,DeepSeek团队写道,“我们希望mHC能重振社区对宏观架构设计的兴趣。通过加深对拓扑结构如何影响优化和表示学习的理解,mHC将有助于解决当前的限制,并有可能为下一代基础架构的发展指明新途径。”

新京报贝壳财经记者 罗亦丹

编辑 岳彩周

校对 柳宝庆