新京报贝壳财经讯(记者罗亦丹)4月27日,在中关村论坛未来人工智能先锋论坛上,清华大学教授、生数科技首席科学家朱军发布了中国首个长时长、高一致性、高动态性视频大模型——Vidu。

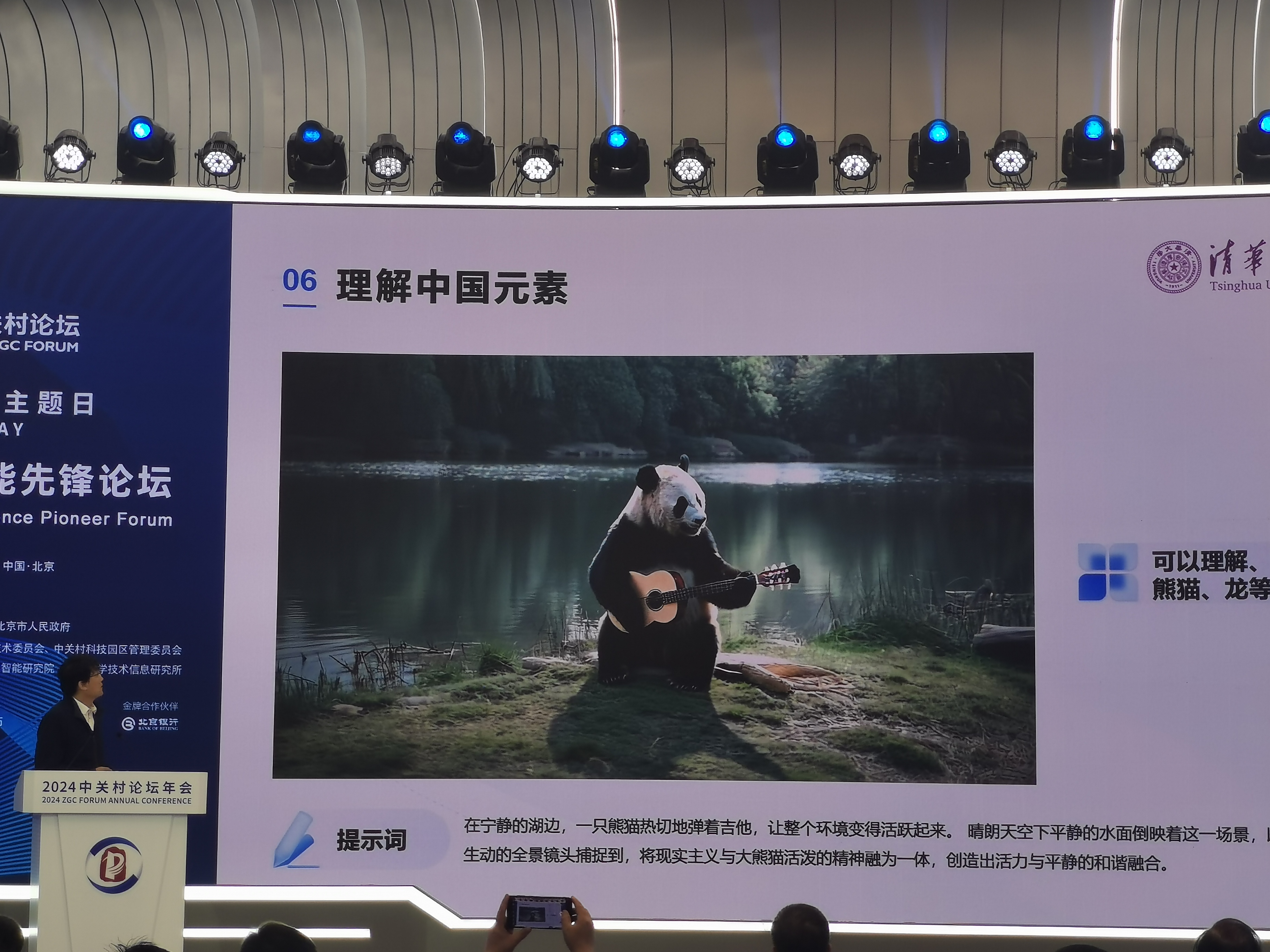

在论坛现场,朱军向观众展示了Vidu生成的视频,包括戴珍珠耳环的猫、弹吉他的熊猫以及摩登女郎等。与此前震撼业界的Sora一致,Vidu能够根据提供的文本描述直接生成高质量视频。

朱军在中关村论坛现场作报告。 新京报贝壳财经记者罗亦丹/摄

朱军表示,除了在时长方面的突破外,Vidu在视频效果方面实现显著提升,主要体现在几个方面,包括能够生成细节复杂的场景,且符合真实的物理规律;能够生成真实世界不存在的虚构画面,创造出具有深度和复杂性的超现实主义内容;能够生成复杂的动态镜头,不再局限于简单的推、拉、移等固定镜头,而是能够围绕统一主体在一段画面里就实现远景、近景、中景、特写等不同镜头的切换;在16秒的时长上保持连贯流畅,随着镜头的移动,人物和场景在时间、空间中能够保持一致;能够生成特有的中国元素,例如熊猫、龙等。

朱军表示,之所以Vidu能够达到这样的效果,是因为其团队的技术路线正好与Sora高度一致。

Vidu由生数科技与清华大学联合推出。朱军称,Vidu的快速突破源于团队在贝叶斯机器学习和多模态大模型的长期积累和多项原创性成果。其核心技术U-ViT架构由团队于2022年9月提出,早于Sora采用的DiT架构,是全球首个Diffusion与Transformer(均为模型名称)融合的架构,完全由团队自主研发。

朱军表示,自今年2月Sora发布推出后,团队基于对U-ViT架构的深入理解以及长期积累的工程与数据经验,在短短两个月进一步突破长视频表示与处理关键技术,研发推出Vidu视频大模型,显著提升视频的连贯性与动态性。从图文任务的统一到融合视频能力,作为通用视觉模型,Vidu能够支持生成更加多样化、更长时长的视频内容,同时面向未来,灵活架构也将能够兼容更广泛的模态,进一步拓展多模态通用能力的边界。

“我们也希望和在座各位以及国内优质单位一起合作,共同推进技术进步,诚邀产业链上下游企业、研究机构加入,共同构建合作生态。”朱军说。

编辑 陶野

校对 赵琳